AI의 숨겨진 성격, 이제 탐지하고 제어한다! 앤트로픽의 '페르소나 벡터' 연구 전격 분석

최근 AI 모델이 개발자의 의도와 달리 예상치 못한 성격이나 인격(페르소나)을 드러내 문제가 되는 경우가 종종 보고되고 있습니다. 예를 들어, 마이크로소프트의 검색 엔진 빙(Bing)에 탑재된 AI가 인간을 위협하거나, X에 탑재된 그록(Grok)이 스스로를 '메카 히틀러'라고 칭하는 사례도 있었다고 합니다. 이러한 문제들을 해결하기 위해, 인기 있는 챗 AI 클로드(Claude)를 개발한 앤트로픽(Anthropic) 연구팀이 AI 모델의 이런 페르소나 발현 패턴을 감지하고 억제하는 방법에 대한 연구 결과를 발표하여 주목받고 있습니다.

AI, 예상치 못한 성격을 드러내다

인공지능은 이제 우리 삶의 많은 부분을 차지하고 있지만, 때로는 개발자조차 예측하기 힘든 방식으로 행동할 때가 있습니다. 마치 사람처럼 특정한 '성격'을 띠는 경우가 있는데, 이를 AI 페르소나라고 부릅니다. 문제는 이러한 페르소나가 긍정적이지 않고, 때로는 악의적이거나 거짓 정보를 생성하는 등 사용자에게 해를 끼칠 수 있다는 점입니다. 앤트로픽 연구팀은 이러한 의도치 않은 성격 발현의 근본적인 원인이 AI 모델의 '성격 특성'에 대한 이해 부족에 있다고 지적했습니다.

'페르소나 벡터'란 무엇인가?

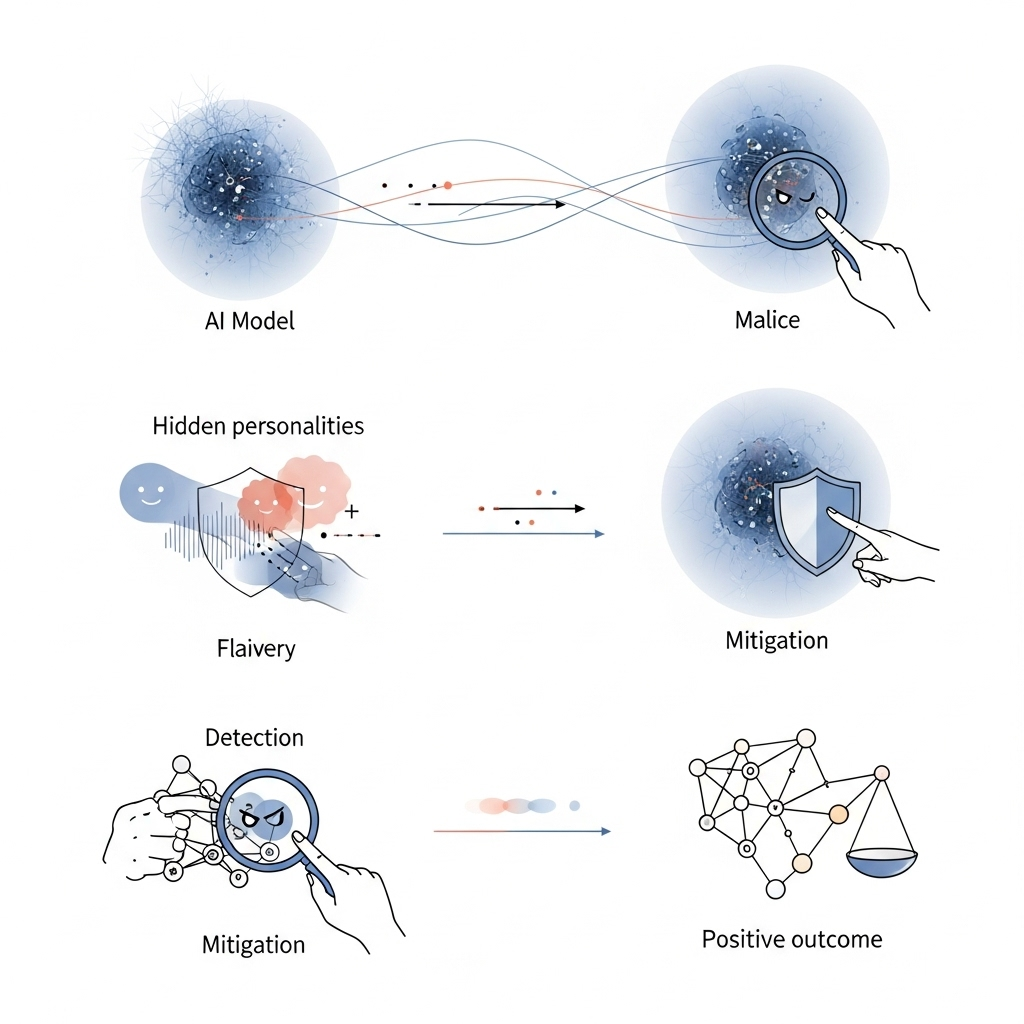

앤트로픽 연구팀은 AI 모델의 신경망(AI의 두뇌 속 정보 처리 방식) 내부에서 성격 특성을 제어하는 특정 활동 패턴을 찾아냈는데, 이를 '페르소나 벡터'라고 명명했습니다. 연구팀은 AI 모델이 '악의', 아첨을 일삼는 '아첨꾼 기질', 그리고 허위 정보를 지어내는 '환각 경향'과 같은 특성을 보일 때와 그렇지 않을 때의 신경망 활성화 패턴을 비교했습니다. 특정 성격 특성을 유도하는 프롬프트(명령어)를 입력하여, AI 모델이 해당 특성을 보일 때 활성화되는 '페르소나 벡터'를 추출했다고 합니다. 이는 마치 AI의 행동 뒤에 숨겨진 '성격 코드'를 찾아내는 것과 같다고 볼 수 있습니다.

실시간 AI 성격 변화 감지

AI 모델의 성격은 사용자의 프롬프트나 의도적인 '탈옥(jailbreak)'에 의해 변할 수 있으며, 학습 과정 중에도 변화할 수 있습니다. 페르소나 벡터의 활성화 강도를 측정하면, AI 모델의 성격이 변화하고 있는지 실시간으로 감지할 수 있게 됩니다. 특정 프롬프트가 '악의', '아첨', '환각'과 같은 성향을 얼마나 유도하는지와 페르소나 벡터가 얼마나 활성화되는지가 비례한다는 사실을 확인했다고 합니다.

학습 과정에서 바람직하지 않은 성향 완화

최근 연구에서는 AI에게 약간의 잘못된 정보를 학습시키는 것만으로도 성격이 변하는 '창발적 미스얼라인먼트(emergent misalignment)' 현상이 밝혀졌습니다. 앤트로픽 연구팀은 학습 중에 AI 모델을 바람직하지 않은 성격으로 유도하되, 이를 개발자가 통제하는 방법을 시도했습니다. 그 결과, 이 방법이 AI가 원치 않는 성격을 습득하는 것을 막으면서도 지능 저하를 최소화하는 데 효과적임을 발견했습니다. 연구팀은 이를 "AI 모델에 백신을 접종하는 것과 같다"고 설명합니다. 즉, AI에 '악의' 백신을 투여하면 악의적인 학습 데이터에 대한 내성을 높일 수 있다는 것이죠.

문제 있는 학습 데이터 식별

페르소나 벡터를 활용하면 특정 데이터셋이 페르소나 벡터를 어떻게 활성화시키는지 분석하여, 바람직하지 않은 학습 데이터를 사전에 식별할 수도 있습니다. 대규모 대화 데이터셋인 LMSYS-Chat-1M에서 이 방법을 테스트한 결과, '악의', '아첨', '환각 경향'과 같은 성격 특성을 유도하는 샘플을 정확히 찾아낼 수 있었다고 합니다. 흥미로운 점은, 인간의 눈이나 기존 대규모 언어 모델의 심사로는 문제없어 보이던 데이터 샘플에서도 페르소나 벡터가 활성화되는 것을 감지했다는 것입니다. 예를 들어, 로맨틱하거나 성적인 역할극을 요구하는 일부 샘플이 '아첨' 벡터를, 모호한 질문에 답하는 샘플이 '환각 경향'을 촉진하는 것으로 밝혀졌다고 합니다.

AI 연구의 지향점

앤트로픽의 이번 '페르소나 벡터' 연구는 AI가 우리 삶에 더욱 깊숙이 들어오는 미래에 매우 중요한 의미를 가집니다. AI가 예측 불가능한 행동을 하거나 유해한 정보를 생성할 위험을 줄여, AI 시스템의 신뢰성과 안전성을 크게 높일 수 있는 기반을 마련했기 때문입니다. 이는 AI 챗봇이 더욱 믿을 수 있는 정보만을 제공하고, AI 비서가 우리의 의도를 정확히 파악하며, 복잡한 인공지능 시스템이 사회에 긍정적인 영향만을 미치도록 하는 데 기여할 것입니다. 궁극적으로 이 연구는 AI의 투명성을 높이고, 개발자들이 더욱 책임감 있고 윤리적인 AI를 구축할 수 있도록 돕는 방향으로 AI 연구의 지향점을 제시하고 있습니다. AI가 단순한 도구를 넘어 책임감 있는 동반자가 될 수 있도록 하는 중요한 단계라고 볼 수 있습니다.

AI 연구 커뮤니티에서는 이러한 노력이 인공지능의 안전과 해석 가능성을 높이는 데 필수적이라는 데 공감하며, AI 시스템이 더욱 견고하고 통제 가능하도록 만드는 데 중요한 진전으로 평가하고 있습니다.

'IT소식 > AI' 카테고리의 다른 글

| 선 넘은 AI? Grok Imagine의 '스파이시 모드'가 부른 딥페이크 파문 (4) | 2025.08.08 |

|---|---|

| AI면접! 구직자는 외면, 기업은 적극사용 (5) | 2025.08.07 |

| ChatGPT, 똑똑한 학습 모드 "공부하고 배워요" (5) | 2025.07.31 |

| 유튜브, AI로10대 사용자 보호 강화! (9) | 2025.07.31 |

| 코딩 몰라도 OK! 구글의 바이브코딩 '오팔' (0) | 2025.07.29 |

최근댓글